其实就是那个 ABCNN的变种,只不过晚发了一段时间,感觉好悲惨

--------------------------

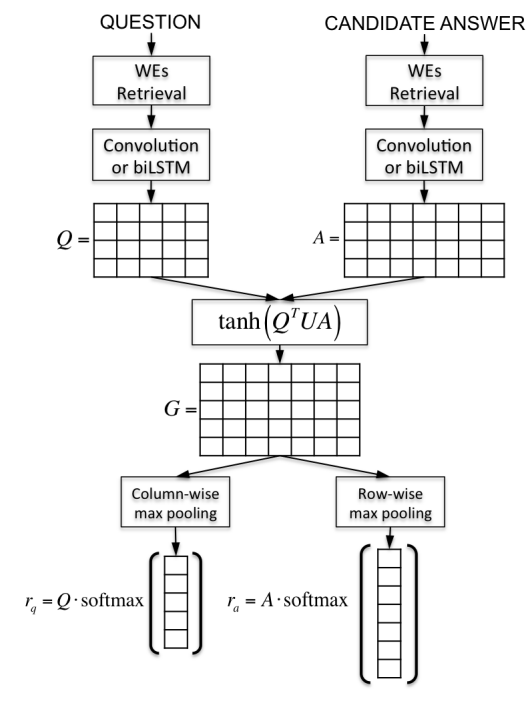

以前的attention 总是单向的,也就是我们往往attend答案,根据问题的表达,但是这样可能会有问题,所以这个文章提出了双向的attention-two way attention 具体的就是

我们看下面这个图

在这个Q和A表达出来后,我们就可以给其中的某一部分给权值了,假设我们的问题的表达Q是d*m的 也就是d是隐层大小,m是句子长度,然后A是d*n的,n是答案长度,那么我们可以有一个矩阵就是我们的attention的,然后我们就开始计算这个attention 首先 这个G是m*n的 我们对这个m*n的矩阵按行取最大,按列取最大可以得到一个m维的向量还有一个n维的向量

然后这个m维的向量softmax一下就得到了一个概率矩阵。

然后我们问题和答案的表达就可以按照下面的这个

======================================================================================

但是这篇文章最牛逼的是把QASENT(07-wang)的那个给发布出来了@!!!!

原味奉上~~

![]()

jacana-qa-naacl2013-data-results.tar.bz2

======================================================================================

最后实验也是一般般吧

回复列表: