这个工作我感觉和我的IJCAI的工作很类似,就是transfer learning 并且验证了它的有效性。

传统的机器翻译模型很棒,特别是在处理标注数据较小的时候,但是现在新的NTM出现了,所以效果很好,在大数据上面,但是这些NTM的方法大多是基于编码解码的

非常data-hungry 所以我们需要对这个问题进行进一步处理。

用transfer learning 在大数据上面训练一个模型 然后在小数据上面重新实验 看看效果怎么样

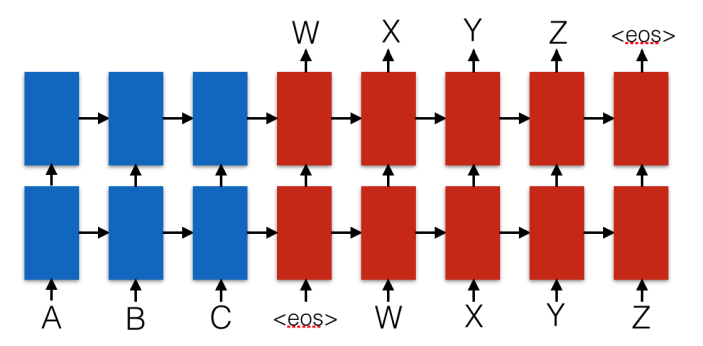

这个就是编码 解码的模型 可以看出来NMT就是RNN应用最多的场合

最后在选择parents models的时候 有这么一个应用

We conclude that the choice of parent model can have a strong impact on transfer models, and choosing better parents for our low resource languages (if data for such parents can be obtained) could improve the final results.

所以还是要选最好很像的家长语言

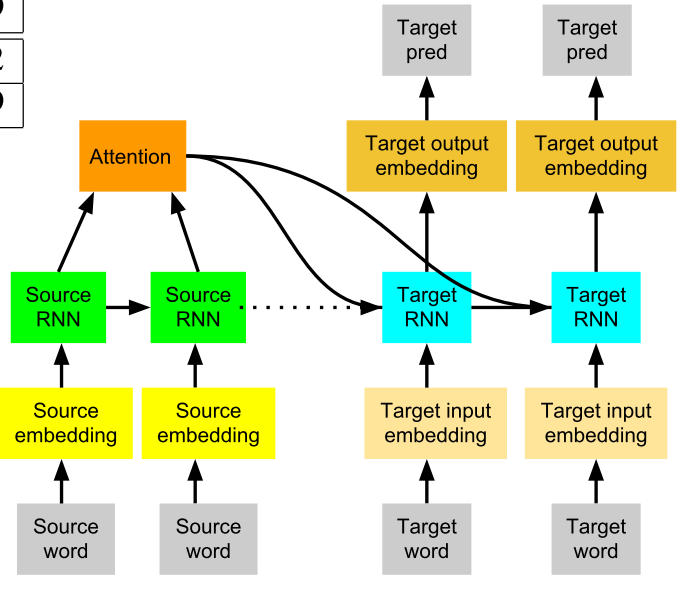

这个是最后它的翻译的模型 看出来还是不错的

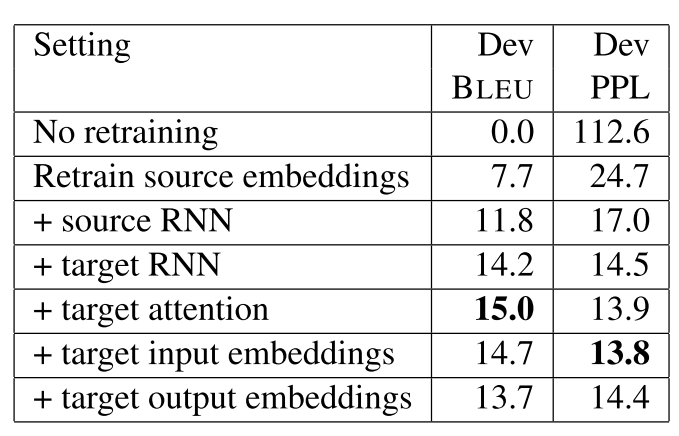

作者还把某一些参数控制不变然后只改变其他的参数 效果如下图所示

可以看出来还是重新训练embedding最好 然后attention也非常好 就是attention

一定要重新训练 这样最后的模型才比较好

没有具体将模型 但是实验分析很好

回复列表: