这个文章有意思

==============================

主要就是讲是不是要求被满足了,也就是在文章中首先找到可能会有要求目的的词语,然后看看最后这个要求是不是被满足。

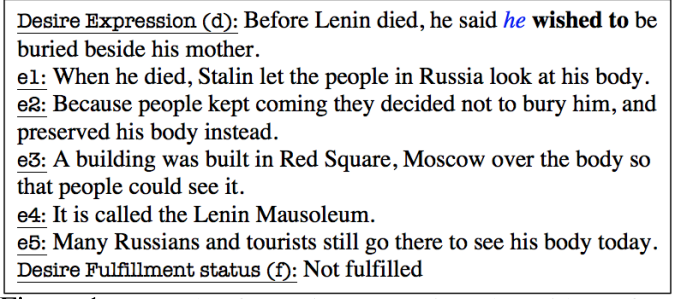

一个典型的结构如下:

其中wished to表示有一个subject 提出了一个 desire 也就是他有一个梦想。然后我们继续看这篇文章,最后看看他的这个愿望是不是被满足了

首先得有数据集,作者是自己构造的 在MCTest和SimpleWIKI上面随便找了一点文章,然后抽出来含有‘wanted to’, ‘wished to’ or ‘hoped to’的句子,然后就把这句话

表征为 desire expression 也就是目标的表达,然后这个表达的背后还有一个文档,来表征这个表达所依托的上下文,这个desire的最后判断都是由这个上下文来的

然后 看看作者提出了几个模型来解决这个问题:

1)RTE 首先我们把desire expression和 Evidence fragments (text) 也就是上下文文档 结合,一句话一句话的,然后看看是不是能够推出来这个desire expression 当然这个desire expression已经被转化成陈述句了

2)unstructure 也就是把整个背景文档看成一个整体,然后看看能不能推出来最后的结果,最后其实就是一个二元分类器,最后看看分类出来的是什么。

3)Latent Structure Narrative Model (LSNM)

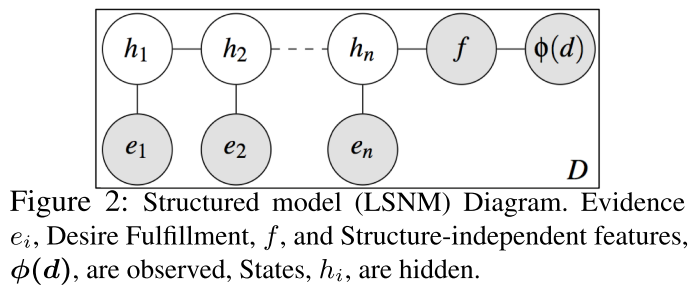

刚才那个是把整个文档综合在一起考虑,但是我们有时候这种模型太粗糙了,所以作者最后就是用了一个结构化的,把其中的过程给model了见下图

其中深色的都是我们观察到的东西

其中的e是我们观察到的evidence 然后h是我们对满足这个人的愿望的置信度,是一个隐变量可以表示为一个等级,

which abstractly represent various degrees of optimism or pessimism with respect to fulfillment,也就是是categoriecal的

然后我们就是一个线性的过程,由这次的evidence 推出这个隐变量,然后再弄成图结构一样的往下走着推理,

这个和普通的图模型的不一样是只有最后一个状态有输出。

最后的f是输出,表征这个愿望是否被满足,然后phi(D)是Structure-independent feature set 表示整体的特征 可以视为刚才那个unstructure的东西

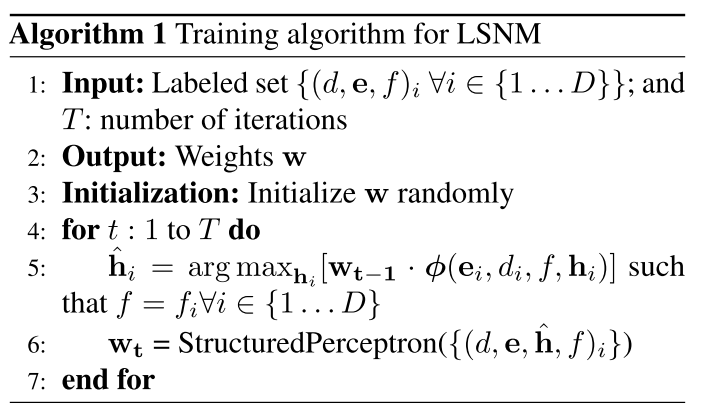

学习过程有点像EM 现实根据当前的权重得到现在的隐变量,然后由最后的输出改变权重,

其中的structurePerceprtron应该是collins当年的那个方法,回头可以再学习一下。

it uses Viterbi algorithm (and weights from previous iteration, w t−1 ) to find the highest scoring latent state sequence, h, that agrees with the provided label (the fulfillment state), f。

==============

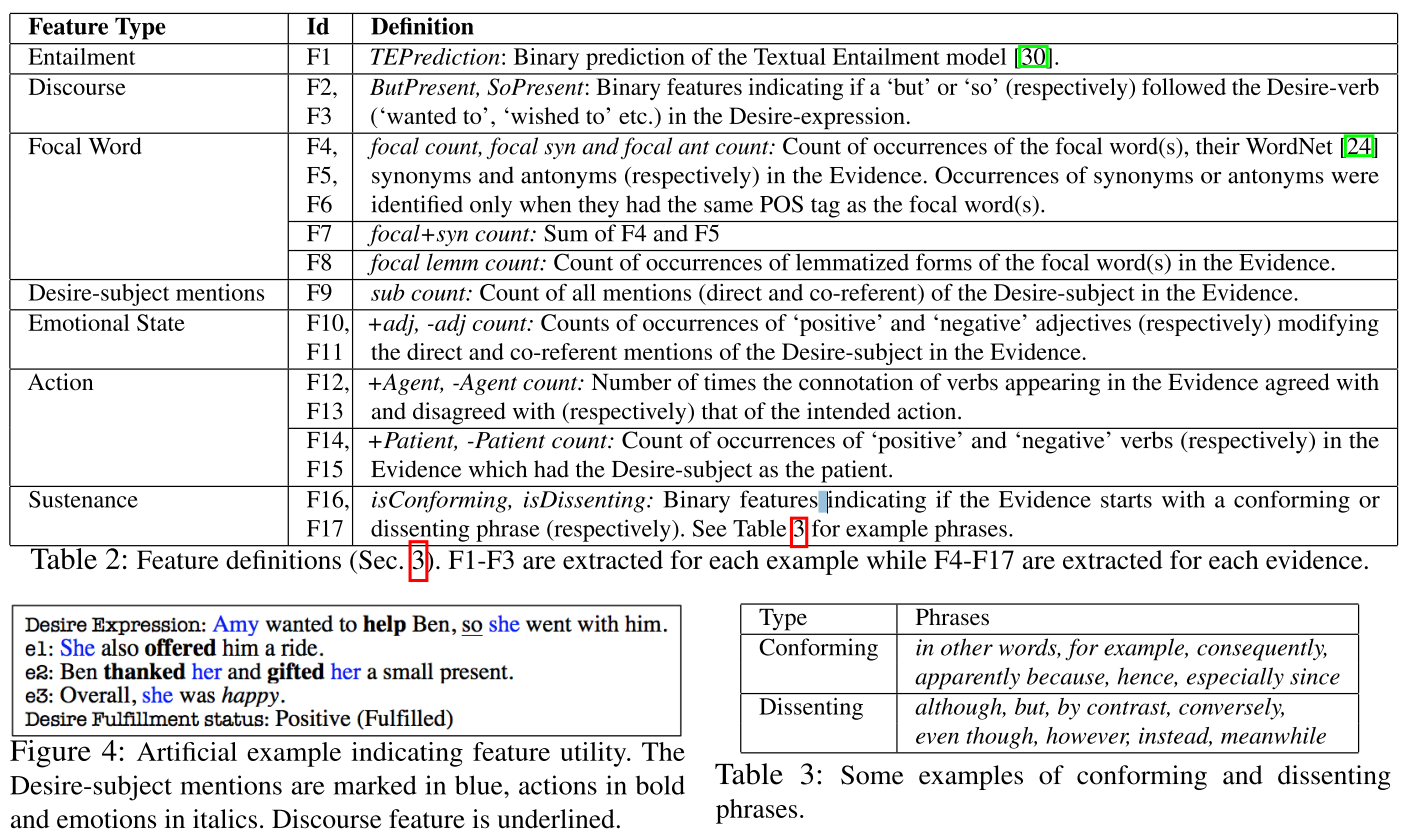

feature

具体看文章中对每一种特征的介绍。

~~~~~~~~~~~~~~~~~~~

unstructure的model用了其中的Discourse features (F1 to F3 in Table 2). For features F4 to F15, we summed their values across all Evidences of an instance.

也就是只有一部分的

----

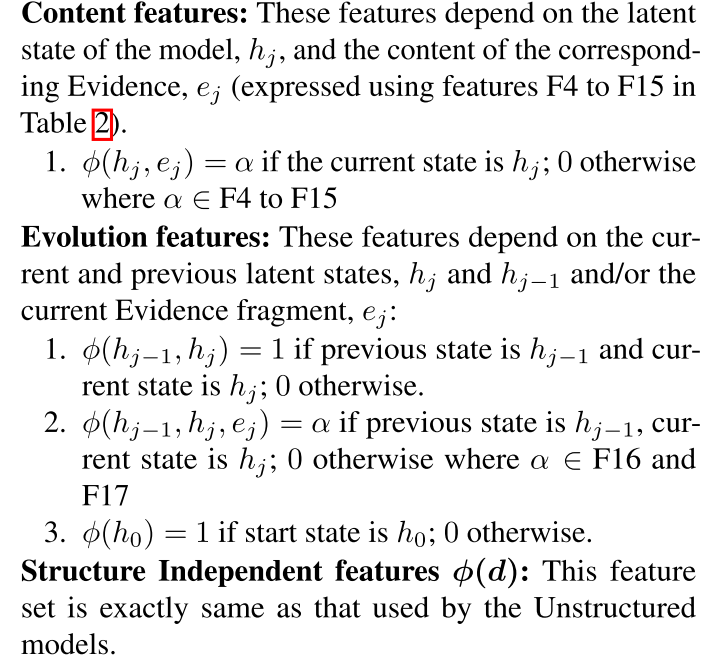

然后对于LSNM 用了下面几个特征:

也就是三种,首先是证据到h的 可能就是一些词项上面的特征。

然后是练个功隐变量上面的等等。

============================

实验

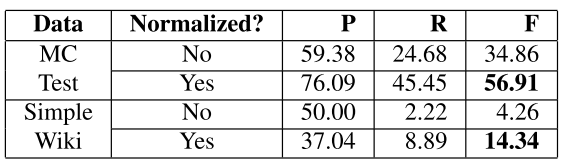

这是用RTE的结果,可以看到要是不normalize(也就是转化成陈述句)结果不太好

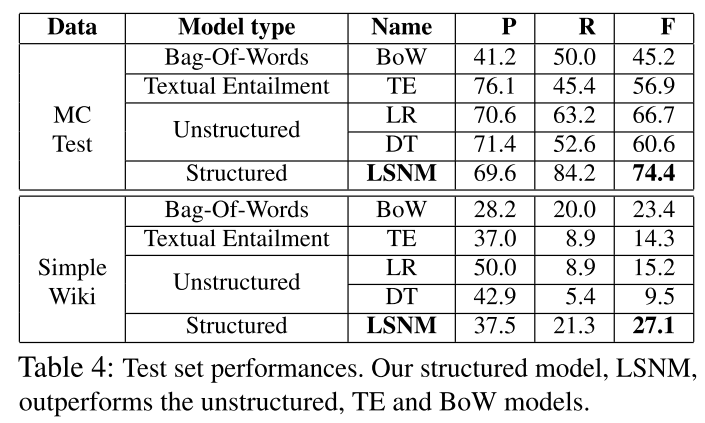

最后的大结果是

看来还是LSNM好

但是要命的是作者最后没有放出数据集!!!这不是坑爹搞笑么

回复列表: