我都不知道要不要发了

=======================================

感觉文章还是很一般

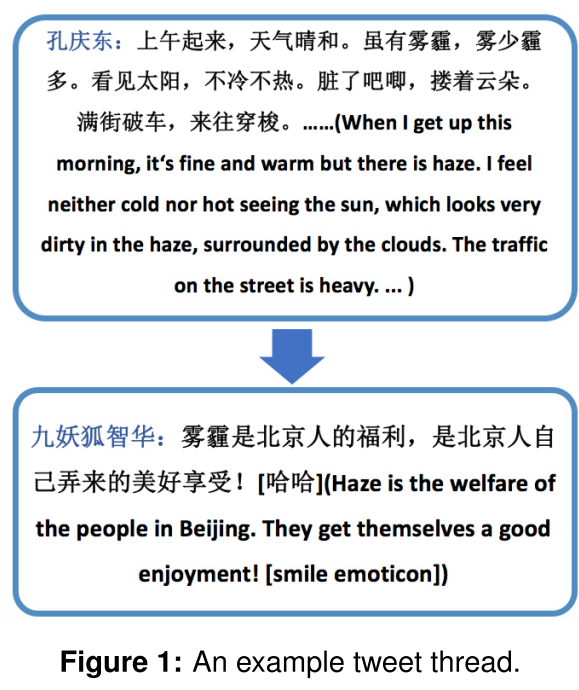

是在情感分析任务中,由于我们一般很少考虑上下文,所以这种很不好,比如我们的twitter的转发,虽然到后来我们看到可能内容已经十分主观褒义了 但是其实我们的根节点还是很悲观的 举一个例子

其中thread指的是从一个根tweet到后来的tweet 这样一个串 叫做一个thread

(PS 其实我开始也不知道这个thread是什么意思 发微博的私信问黄民烈 他没有鸟我

)

不说废话了

作者在这个文章中就是把这个上下文也考虑进去了

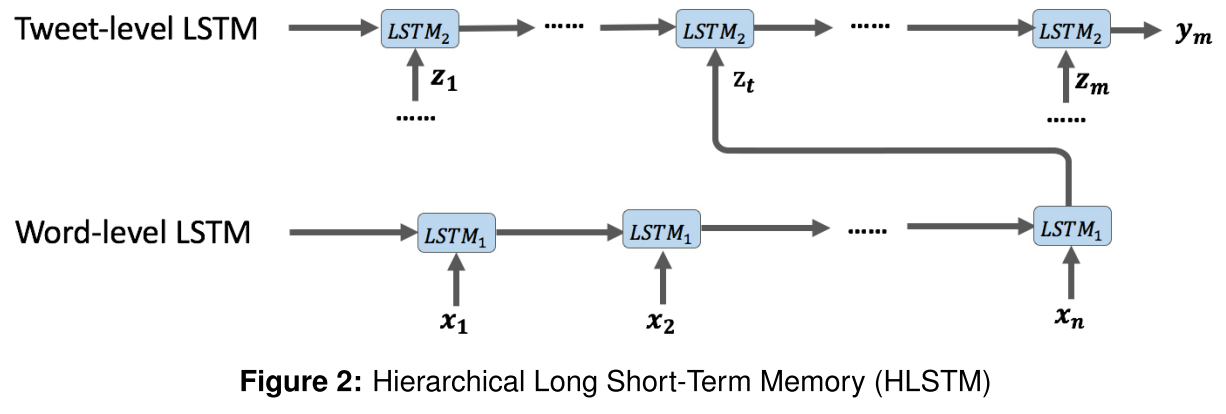

其实就是这样一个结构

先是把单个的tweet用lstm给model了 然后再stack一层lstm 呵呵呵呵呵呵呵呵呵呵呵呵呵呵呵呵呵呵

作者还加了一个additional context 因为这和CLSTM很像,就是把lstm里面的gate加一点上下文信息进去

上下文信息作者在这里用的是传统的特征工程里面的那种0 1 的特征向量,这样的特征一共加了好几个 然后就变成了一个向量,然后我们把这个向量通过一个矩阵投影到LSTM的隐空间

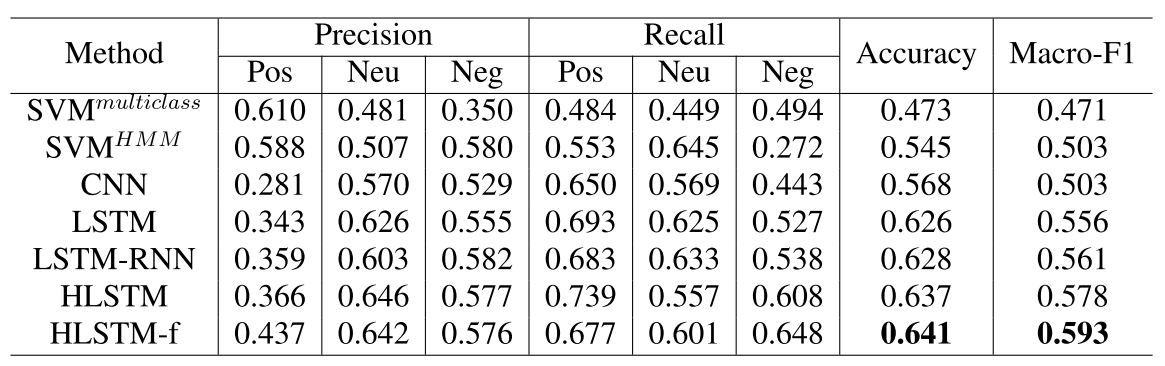

实验效果

数据:

We collected tweets from a Chinese Microblog website , Weibo.com. In Weibo.com, the retweets and replies always maintain their preced- ing tweets during the propagation process, and therefore long-range contexts are visible to a cur- rent tweet. We collected about 15k tweets con- sisting of over 1.6k tweet threads of 51 topics. We should notice that a tweet thread forms a tree structure started with an origin tweet, and the other nodes in the tree are retweets or replies. The av- erage number of tweets in all the threads is 8.93, and the average depth is 3.75.

结果: 看起来一般

主要是没代码 没数据(虽然他说数据是自己做的)

回复列表: