==================================================================

文章的思路就是要加速LSTM等这种循环神经网络

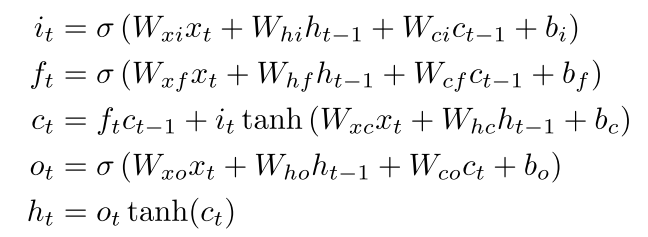

我们知道以往的循环神经网络都是这样:

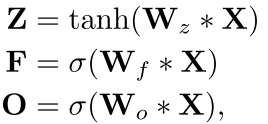

因为是随着时间序列的 所以每一步 都要算很多sigmoid tanh等操作 所以这样很费时间

这篇文章的核心就是我把费事的那些操作 比如sigmoid 还有矩阵乘给从循环中拿出来,就是每一个时间步骤单独算

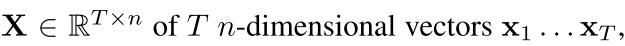

一个

然后我们可以对这个序列用m个卷积核做卷积操作,得到一个

这样的东西我们就可以当作原始的特征了

同时,除了这个z我们还可以把LSTM里面的那些门也给都离开来,每一步都有这么一个门,来控制

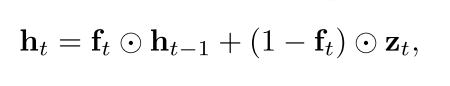

所以我们现在就有这样的一个序列,有一些输入信息Z 还有一些LSTM的门 然后我们再对这些进行循环操作,得到时间序列的东西

注意现在所有的循环的操作都是只有这一点了 而这个循环的式子比最上面那个传统的花时间的LSTM里面的循环简单多了,因为只有矩阵相乘的操作,所以

会非常快。( Although the recurrent parts of these functions must be calculated for each timestep in sequence, their simplicity and parallelism along feature dimensions means that, in practice, evaluating them over even long sequences requires a negligible amount of computation time.

)

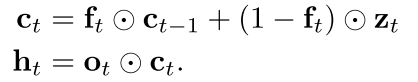

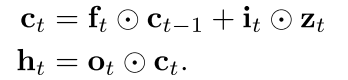

也可以对这个做出扩展,包含有输出门或者输入门……

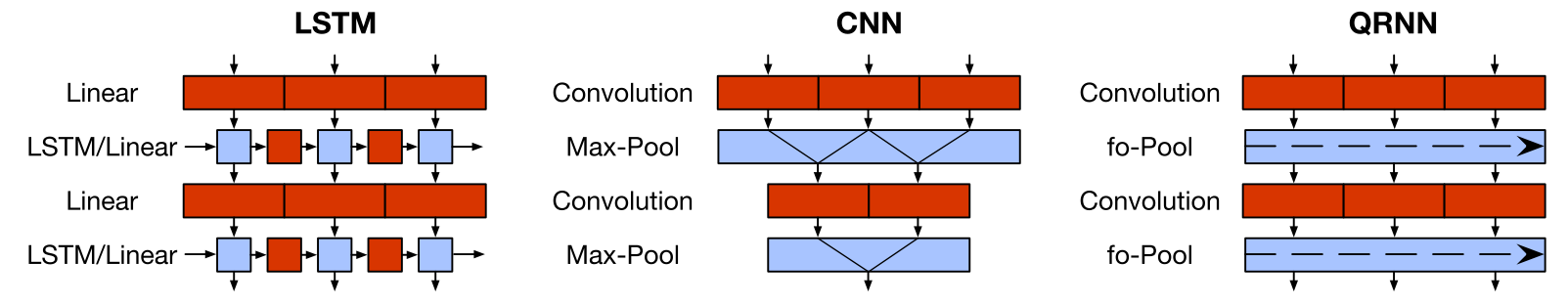

整个的模型如下图:

实验是在一些小东西是上面做的

Experiments on language modeling, sentiment classification, and character-level

neural machine translation demonstrate these advantages

回复列表: